Hirdetés

Ha te weboldalt üzemeltetni 10 módszer egy kicsi és egyszerű webhely létrehozására túlzás nélkülA WordPress túlzás lehet. Amint azt ezek a kiváló szolgáltatások is bizonyítják, a WordPress nem a webhelykészítés lényege. Ha egyszerűbb megoldásokat szeretne, sokféle közül válogathat. Olvass tovább , valószínűleg hallott már a robots.txt fájlról (vagy a „robotok kizárási szabványáról”). Akár van, akár nem, itt az ideje, hogy tanuljon róla, mert ez az egyszerű szöveges fájl kulcsfontosságú része webhelyének. Lehet, hogy jelentéktelennek tűnik, de meg fog lepődni, hogy mennyire fontos.

Vessen egy pillantást arra, hogy mi a robots.txt fájl, mit csinál, és hogyan állíthatja be megfelelően a webhelyéhez.

Mi az a robots.txt fájl?

A robots.txt fájl működésének megértéséhez ismernie kell egy kicsit a keresőmotorokról Hogyan működnek a keresőmotorok?Sok ember számára a Google az internet. Vitathatatlanul ez a legfontosabb találmány az internet óta. És bár a keresőmotorok sokat változtak azóta, a mögöttes elvek továbbra is ugyanazok. Olvass tovább

. A rövid verzió az, hogy „bejárókat” küldenek ki, amelyek információért keresik az internetet. Ezután ezekből az információk egy részét tárolják, hogy később irányíthassák az embereket.Ezek a robotok, más néven „botok” vagy „pókok”, több milliárd webhelyről találnak oldalakat. A keresőmotorok útbaigazítást adnak nekik, hogy merre menjenek, de az egyes webhelyek is kommunikálhatnak a robotokkal, és megmondhatják nekik, hogy mely oldalakat kell nézniük.

Legtöbbször az ellenkezőjét teszik, és megmondják nekik, hogy melyik oldalakon nem kellene nézni. Olyan dolgok, mint például adminisztratív oldalak, háttérportálok, kategória- és címkeoldalak, és egyéb dolgok, amelyeket a webhelytulajdonosok nem szeretnének, hogy megjelenjenek a keresőmotorokon. Ezeket az oldalakat továbbra is láthatják a felhasználók, és bárki hozzáférhet, aki rendelkezik engedéllyel (ami gyakran mindenki).

De azzal, hogy megmondja a pókoknak, hogy ne indexeljenek egyes oldalakat, a robots.txt fájl mindenkinek szívességet tesz. Ha a „MakeUseOf” kifejezésre keresett egy keresőben, szeretné, ha adminisztratív oldalaink előkelő helyen jelennének meg a rangsorban? Nem. Ez senkinek nem tenne jót, ezért azt mondjuk a keresőmotoroknak, hogy ne jelenítsék meg őket. Használható arra is, hogy a keresőmotorok ne nézzenek meg olyan oldalakat, amelyek esetleg nem segítenek besorolni webhelyét a keresési eredmények között.

Röviden: a robots.txt megmondja a webrobotoknak, hogy mit kell tenniük.

A feltérképező robotok figyelmen kívül hagyhatják a robots.txt fájlt?

A robotok figyelmen kívül hagyják a robots.txt fájlokat? Igen. Valójában sok csúszómászó csináld ignoráld. Általában azonban ezek a robotok nem jó hírű keresőmotoroktól származnak. Spammerektől, e-mail-gyűjtőktől és más típusú automatizált robotok Hogyan készítsünk egyszerű webrobotot információk lekéréséhez egy webhelyrőlSzeretett volna valaha információkat rögzíteni egy webhelyről? Így írhat bejárót, amellyel navigálhat egy webhelyen, és kivonhatja azt, amire szüksége van. Olvass tovább amelyek az interneten barangolnak. Ezt fontos szem előtt tartani – nem hatékony biztonsági intézkedés, ha a robotok kizárására vonatkozó szabványt használjuk a botoknak, hogy távol maradjanak. Valójában néhány bot talán Rajt azokkal az oldalakkal, amelyekre azt mondod, hogy ne menjenek.

A keresőmotorok azonban a robots.txt fájl által előírtak szerint fognak működni, amennyiben helyesen van formázva.

Hogyan írjunk robots.txt fájlt

Van néhány különböző rész, amely egy robotkizárási szabványfájlba kerül. Itt külön-külön lebontom őket.

Felhasználói ügynök nyilatkozata

Mielőtt megmondaná egy botnak, hogy mely oldalakat ne nézze meg, meg kell adnia, hogy melyik bottal beszél. Legtöbbször egy egyszerű deklarációt használ, ami azt jelenti, hogy „minden bot”. Ez így néz ki:

User-agent: *A csillag az „összes robotot” jelenti. Megadhat azonban oldalakat bizonyos robotokhoz. Ehhez tudnia kell annak a botnak a nevét, amelyre iránymutatást ad. Ez így nézhet ki:

Felhasználói ügynök: Googlebot. [a nem feltérképezendő oldalak listája] User-agent: Googlebot-Image/1.0. [a nem feltérképezendő oldalak listája] Felhasználói ügynök: Bingbot. [a nem feltérképezendő oldalak listája]Stb. Ha olyan robotot talál, amelynél egyáltalán nem szeretné feltérképezni webhelyét, ezt is megadhatja.

A felhasználói ügynökök nevének megkereséséhez keresse fel a useragentstring.com webhelyet [nem érhető el].

Oldalak letiltása

Ez a robotkizárási fájl fő része. Egy egyszerű nyilatkozattal megmondja egy botnak vagy botcsoportnak, hogy ne térképezzen fel bizonyos oldalakat. A szintaxis egyszerű. A következőképpen tilthatja le a hozzáférést a webhelye „admin” könyvtárában található összeshez:

Disallow: /admin/Ez a sor megakadályozza, hogy a robotok feltérképezzenek a yoursite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html és bármi mást, ami az admin könyvtárba tartozik.

Egyetlen oldal letiltásához egyszerűen adja meg azt a letiltási sorban:

Disallow: /public/exception.htmlMost a „kivétel” oldal nem lesz kirajzolva, de minden más a „nyilvános” mappában igen.

Ha több könyvtárat vagy oldalt szeretne felvenni, egyszerűen sorolja fel őket a következő sorokban:

Disallow: /privát/ Disallow: /admin/ Disallow: /cgi-bin/ Disallow: /temp/Ez a négy sor a szakasz tetején megadott bármelyik felhasználói ügynökre vonatkozik.

Ha azt szeretné, hogy a robotok ne nézzék meg webhelye egyik oldalát sem, használja ezt:

Letiltás: /Különböző szabványok felállítása a robotokra

Mint fentebb láttuk, megadhat bizonyos oldalakat a különböző robotokhoz. Az előző két elemet kombinálva így néz ki:

User-agent: googlebot. Disallow: /admin/ Disallow: /private/ User-agent: bingbot. Disallow: /admin/ Disallow: /privát/ Disallow: /titkos/Az „admin” és a „privát” rész láthatatlan lesz a Google-on és a Bingen, de a Google látni fogja a „titkos” könyvtárat, míg a Bing nem.

Az összes botra általános szabályokat adhat meg az Asterisk user agent használatával, majd a következő szakaszokban konkrét utasításokat is adhat a botoknak.

Mindent összerakva

A fenti ismeretekkel komplett robots.txt fájlt írhatsz. Csak indítsa be kedvenc szövegszerkesztőjét (mi a Sublime rajongói 11 fenséges szöveges tipp a termelékenységhez és a gyorsabb munkafolyamathozA Sublime Text egy sokoldalú szövegszerkesztő, és sok programozó aranystandardja. Tippjeink a hatékony kódolásra összpontosítanak, de az általános felhasználók értékelni fogják a billentyűparancsokat. Olvass tovább itt), és kezdje el tudatni a robotokkal, hogy webhelye bizonyos részein nem látják őket szívesen.

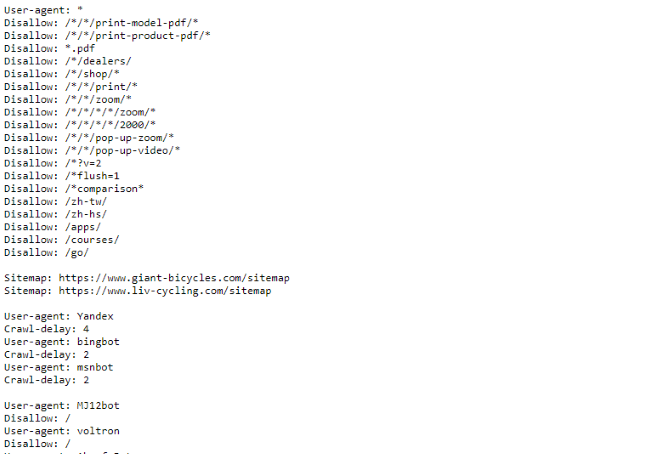

Ha szeretne egy példát látni egy robots.txt fájlra, egyszerűen lépjen bármelyik webhelyre, és adja hozzá a „/robots.txt” szöveget a végéhez. Íme a Giant Bicycles robots.txt fájl egy része:

Amint látja, jó néhány oldal van, amelyet nem akarnak megjelenni a keresőkben. Néhány dolgot is tartalmaztak, amelyekről még nem beszéltünk. Nézzük meg, mit tehet még a robotkizárási fájlban.

Webhelytérképének megtalálása

Ha a robots.txt fájl megmondja a robotoknak, hogy hol nem menni, a tiéd A sitemap ennek az ellenkezőjét teszi XML-webhelytérkép létrehozása 4 egyszerű lépésbenKétféle webhelytérkép létezik – HTML-oldal vagy XML-fájl. A HTML-webhelytérkép egy olyan oldal, amely a látogatóknak megjeleníti a webhely összes oldalát, és általában azokra mutató hivatkozásokat tartalmaz... Olvass tovább , és segít nekik megtalálni, amit keresnek. És bár a keresőmotorok valószínűleg már tudják, hol található az oldaltérkép, nem árt, ha újra tudatja velük.

A webhelytérkép helyére vonatkozó deklaráció egyszerű:

Webhelytérkép: [webhelytérkép URL-je]Ez az.

A saját robots.txt fájlunkban így néz ki:

Webhelytérkép: //www.makeuseof.com/sitemap_index.xmlEz minden benne van.

Feltérképezési késleltetés beállítása

A feltérképezési késleltetési irányelv megmondja bizonyos keresőmotoroknak, hogy milyen gyakran indexelhetik a webhely egy oldalát. Másodpercekben mérik, bár egyes keresőmotorok kissé eltérően értelmezik. Egyesek úgy látják, hogy az 5-ös feltérképezési késleltetés azt jelzi, hogy várjon öt másodpercet minden feltérképezés után, hogy elindítsa a következőt. Mások utasításként értelmezik, hogy öt másodpercenként csak egy oldalt kell feltérképezni.

Miért mondaná meg egy bejárónak, hogy lehetőleg ne mászzon? Nak nek sávszélesség megőrzése 4 módja annak, hogy a Windows 10 pazarolja az internetes sávszélességetA Windows 10 pazarolja az internetes sávszélességet? Az alábbiakban bemutatjuk, hogyan ellenőrizheti, és mit tehet annak megállítására. Olvass tovább . Ha a szerver nem tud lépést tartani a forgalommal, érdemes feltérképezési késleltetést beállítani. Általában a legtöbb embernek nem kell aggódnia emiatt. A nagy, nagy forgalmú webhelyeknek azonban érdemes lehet kísérletezni egy kicsit.

A következőképpen állíthatja be a nyolc másodperces feltérképezési késleltetést:

Feltérképezés késleltetése: 8Ez az. Nem minden keresőmotor engedelmeskedik az utasításának. De nem árt megkérdezni. Az oldalak letiltásához hasonlóan különböző feltérképezési késleltetéseket is beállíthat bizonyos keresőmotorokhoz.

A robots.txt fájl feltöltése

Miután beállította a fájlban található összes utasítást, feltöltheti a webhelyére. Győződjön meg arról, hogy ez egy egyszerű szöveges fájl, és a neve robots.txt. Ezután töltse fel webhelyére, hogy megtalálja a yoursite.com/robots.txt címen.

Ha használ a tartalomkezelő rendszer 10 legnépszerűbb online tartalomkezelő rendszerA kézzel kódolt HTML-oldalak és a CSS elsajátításának napjai régen elmúltak. Telepítsen egy tartalomkezelő rendszert (CMS), és perceken belül elkészítheti a webhelyet, amelyet megoszthat a világgal. Olvass tovább mint a WordPress, valószínűleg van egy konkrét módszer, amivel ezt meg kell tennie. Mivel az egyes tartalomkezelő rendszerekben eltérő, olvassa el a rendszer dokumentációját.

Egyes rendszereknek online felülete is lehet a fájl feltöltéséhez. Ezekhez csak másolja és illessze be az előző lépésekben létrehozott fájlt.

Ne felejtse el frissíteni a fájlt

Az utolsó tanács, amit adok, hogy időnként nézze át a robot kizárási fájlját. A webhely megváltozik, és előfordulhat, hogy néhány módosítást kell végrehajtania. Ha furcsa változást észlel a keresőmotor forgalmában, érdemes a fájlt is megnézni. Az is lehetséges, hogy a szabványos jelölés a jövőben megváltozhat. Mint minden mást a webhelyén, itt is érdemes időnként megnézni.

Mely oldalakról zárja ki a feltérképező robotokat a webhelyén? Észrevett valami különbséget a keresőmotorok forgalmában? Ossza meg tanácsait és megjegyzéseit alább!

Dann tartalomstratégiai és marketing tanácsadó, aki segít a vállalatoknak keresletet és leadeket generálni. Stratégiáról és tartalommarketingről is ír blogot a dannalbright.com oldalon.